فهرست مطالب:

- چه زمانی باید از پارتیشن در اسپارک استفاده کنم؟

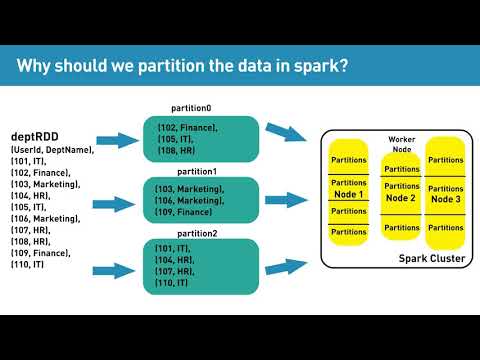

- چرا باید داده ها را پارتیشن بندی کنیم؟

- چند پارتیشن باید spark داشته باشم؟

- پارتیشن های spark shuffle چیست؟

تصویری: چرا به پارتیشن در اسپارک نیاز داریم؟

2024 نویسنده: Fiona Howard | [email protected]. آخرین اصلاح شده: 2024-01-10 06:36

پارتیشن بندی به کمک می کند تا به میزان قابل توجهی مقدار عملیات I/O را که پردازش داده ها را تسریع می کند به حداقل برساند Spark بر اساس ایده محلی بودن داده است. این نشان می دهد که برای پردازش، گره های کارگر از داده هایی استفاده می کنند که به آنها نزدیک تر است. در نتیجه، پارتیشن بندی ورودی/خروجی شبکه را کاهش می دهد و پردازش داده ها سریعتر می شود.

چه زمانی باید از پارتیشن در اسپارک استفاده کنم؟

پارتیشن بندی Spark/PySpark یک روش برای تقسیم داده ها به چندین پارتیشن است، به طوری که می توانید تبدیل ها را روی چند پارتیشن به صورت موازی اجرا کنید که به شما امکان می دهد کار را سریعتر تکمیل کنید. همچنین می توانید داده های پارتیشن بندی شده را در یک سیستم فایل (چند دایرکتوری فرعی) برای خواندن سریعتر توسط سیستم های پایین دست بنویسید.

چرا باید داده ها را پارتیشن بندی کنیم؟

در بسیاری از راه حل های مقیاس بزرگ، داده ها به پارتیشن هایی تقسیم می شوند که می توان آنها را به طور جداگانه مدیریت کرد و به آنها دسترسی داشت. پارتیشن بندی می تواند مقیاس پذیری را بهبود بخشد، مشاجره را کاهش دهد و عملکرد را بهینه کند… در این مقاله، اصطلاح پارتیشن بندی به معنای فرآیند تقسیم فیزیکی داده ها به فروشگاه های داده جداگانه است.

چند پارتیشن باید spark داشته باشم؟

توصیه کلی برای Spark این است که 4 برابر پارتیشن به تعداد هستههای موجود در کلاستر برای برنامه کاربردی داشته باشید، و برای کران بالایی - اجرای کار باید بیش از 100 میلیثانیه زمان نیاز داشته باشد..

پارتیشن های spark shuffle چیست؟

Shuffle پارتیشنهای پارتیشنهای spark dataframe هستند که با استفاده از عملیات گروهبندی یا پیوستن ایجاد میشوند. تعداد پارتیشن های این دیتافریم با پارتیشن های دیتافریم اصلی متفاوت است. … این نشان می دهد که دو پارتیشن در دیتافریم وجود دارد.

توصیه شده:

چرا به نوارهای کناری نیاز داریم؟

در ارتباطات رادیویی، باند جانبی باندی از فرکانسهای بالاتر یا پایینتر از فرکانس حامل است که نتیجه فرآیند مدولاسیون است. نوارهای جانبی حامل اطلاعات ارسال شده توسط سیگنال رادیویی باندهای جانبی شامل تمام اجزای طیفی سیگنال مدوله شده به جز حامل هستند .

چرا به ایزومورفیسم نیاز داریم؟

از آنجایی که یک ایزومورفیسم برخی از جنبه های ساختاری یک مجموعه یا گروه ریاضی را حفظ می کند ، اغلب برای نگاشت یک مجموعه پیچیده بر روی یک مجموعه ساده تر یا شناخته شده به منظور ایجاد استفاده می شود. ویژگی های مجموعه اصلی ایزومورفیسم یکی از موضوعاتی است که در نظریه گروه مورد مطالعه قرار می گیرد .

چرا به سلولز نیاز داریم؟

سلولز ماده اصلی در دیواره سلول های گیاهی است، به گیاهان کمک می کند تا سفت و راست بمانند انسان نمی تواند سلولز را هضم کند، اما در رژیم غذایی به عنوان فیبر مهم است. فیبر به سیستم گوارش شما کمک می کند - باعث حرکت غذا در روده و دفع مواد زائد از بدن می شود.

چرا به ایزوتوپ نیاز داریم؟

ایزوتوپهای یک عنصر همگی رفتار شیمیایی یکسانی دارند، اما ایزوتوپهای ناپایدار در طولدچار فروپاشی خودبهخودی میشوند که تابش ساطع میکنند و به حالت پایداری میرسند. این خاصیت رادیو ایزوتوپ ها در نگهداری مواد غذایی، قدمت باستان شناسی مصنوعات و تشخیص و درمان پزشکی مفید است .

چرا به تشک ضد الکتریسیته ساکن نیاز داریم؟

مانند سایر اشکال تجهیزات ایمنی ساکن، تشک های ESD عملکردی دوگانه دارند: الکتریسیته ساکن افراد یا اشیاء را از بین می برند و همچنین از تجمع الکتریسیته ساکن جلوگیری می کنند. در محیط کار . چرا باید از تشک ضد الکتریسیته ساکن استفاده کنید؟ یک تشک ضد الکتریسیته ساکن طراحی شده است تا به کاهش اثرات تخلیه الکترواستاتیک (ESD) بر روی یک جزء فردی یا حساس به استاتیک کمک کند.